Le miroir aux alouettes de la transition écologique

Fabrice Flipo

La France va prendre le tournant de la 5G […].

J’entends beaucoup de voix qui s’élèvent pour

expliquer qu’il nous faudrait relever la complexité des

problèmes contemporains en revenant à la lampe à huile.

Je ne crois pas au modèle Amish, et je ne crois pas que le

modèle Amish permette de régler les défis de

l’écologie contemporaine.

Emmanuel Macron

Qu’est-ce que la transition écologique ? Le Green New Deal proposé récemment par la Commission européenne [1] en donne un exemple particulièrement abouti, salué par les ONG et les partis écologistes. Avec ce plan, qui vise la neutralité carbone d’ici 30 ans, l’Europe paraît prendre ses responsabilités, en termes d’objectifs. Et pourtant on peut se demander si le véritable objectif de ce programme n’est pas d’assurer des débouchés pour le numérique et les autres produits supposément « verts ». La grande oubliée, c’est la sobriété, et avec elle, une mise en cause du productivisme. Avec, à la clé, bien peu de chances d’atteindre les objectifs annoncés.

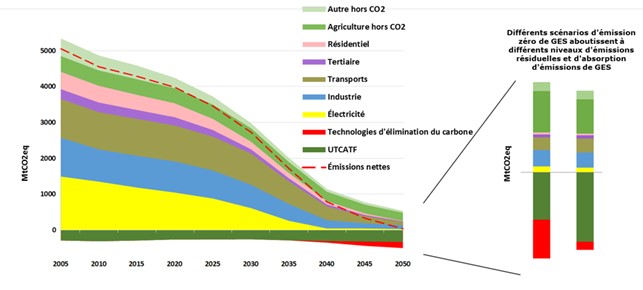

Pour rester sous les 1,5° C, la nouvelle feuille de route va bien au-delà des simples mesures d’efficacité énergétique et de croissance des énergies renouvelables de l’ancien « paquet climat » [2]. Le Green Deal ne vise rien moins que l’absence d’émission de gaz à effet de serre nette d’ici 2050. L’Europe se positionnerait en même temps en leader mondial de « l’économie verte ». Les citoyens et leur participation active seraient au cœur du dispositif. Des investissements publics et privés seraient « l’occasion de mettre résolument l’Europe sur une nouvelle voie, celle d’une croissance durable et inclusive. Le pacte vert pour l’Europe accélérera et étaiera la transition nécessaire dans l’ensemble des secteurs » [3]. Dans ce but, le Green Deal s’appuie sur un ensemble de politiques qui s’inscrivent dans une dynamique de directives dont la construction s’étale sur plusieurs décennies, qui portent principalement sur l’efficacité énergétique, les déchets, l’écoconception, l’économie circulaire, l’achat public et l’information des consommateurs. L’essentiel est rappelé dans la Communication « Une planète propre pour tous - Une vision européenne stratégique à long terme pour une économie prospère, moderne, compétitive et neutre pour le climat » (2018) [4]. L’UE pense avoir ainsi réalisé le découplage tant attendu : « en conséquence [des réglementations déjà adoptées], entre 1990 et 2016, la consommation d’énergie a diminué de près de 2 % et les émissions de gaz à effet de serre de 22 %, tandis que le PIB a progressé de 54 % […]. La part des énergies renouvelables dans la consommation finale d’énergie est passée de 9 % en 2005 à 17 % aujourd’hui » [5]. La solution est donc d’aller plus loin : plus de renouvelables, plus d’efficacité matière et énergie, plus de produits « verts ».

Le jeu de rôles est identifié : d’un côté les producteurs de produits propres, de l’autre des citoyens qui les achètent ; et comme aucun des deux acteurs n’existe réellement, des réglementations et des incitations doivent permettre d’atteindre le but. « L’engagement du consommateur, notamment par l’intermédiaire d’associations, sera un élément clé dans ce processus. » [6]. L’affaire serait même rentable, financée par les économies réalisées sur les fossiles (entre 150 et 200 milliards d’euros par an), à quoi s’ajoute une facture sanitaire évitée de 200 milliards/an, et la perspective d’exportation de produits « verts » [7]. Enfin des millions d’emplois sont à la clé, avec des mécanismes d’aide à la reconversion pour les secteurs touchés, et un soutien pour les plus bas revenus.

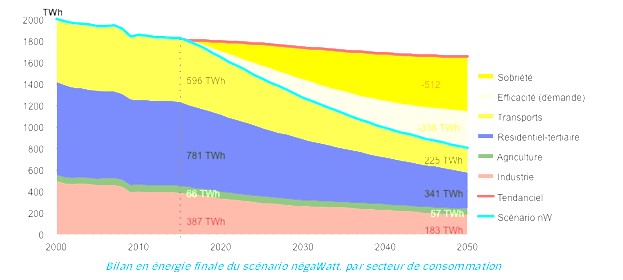

Efficacité, renouvelables, courbe avec une forte décroissance de la consommation d’énergie, promesses importantes d’emploi : tout indique que les partisans du scénario négawatt ont remporté un combat historique, à la fois culturel (sur les valeurs, sur la manière de cadrer les enjeux) et politique (textes officiels à la clé).

Ce n’est évidemment pas si simple. L’Union reconnaît dans le même temps que « les efforts doivent se poursuivre pour surmonter la récente stagnation des améliorations dans le domaine de l’efficacité énergétique et des réductions d’émissions de gaz à effet de serre » [8]. Le propos est un peu surprenant, au premier abord : ainsi, alors que les tendances sont bonnes et que l’UE se félicite de ses réglementations, les résultats ne seraient pas à la hauteur ? Pourquoi ? L’Europe donne la réponse : la cause première du marasme est la croissance économique, avant la décroissance tendancielle des gains en efficacité énergétique, notamment dans le transport aérien, la forte croissance des SUV et l’ajustement réalisé suite à la triche du secteur automobile (+ 30 % !) [9]. Rappelons que les SUV sont nés d’une tentative réussie de contournement des règles de pollution, aux États-Unis [10]. Plus grave, un bilan des émissions aux frontières montre une croissance de 8 % des émissions de l’UE, sur la période 1990-2010, pourtant très favorable, en raison notamment de la crise de 2008 et de la chute du PIB des pays d’Europe centrale et orientale, liée à la fin de l’URSS [11]. Les signaux sont donc bien moins au vert que ne le dit la comptabilité carbone diplomatique, qui ne compte que les émissions occasionnées sur le territoire même de l’UE.

Un problème plus important encore vient du rôle attendu ou espéré du numérique. Pour le Pacte, « les technologies numériques s’avèrent d’une importance cruciale pour atteindre les objectifs fixés par le pacte vert en matière de développement durable, et ce dans une grande variété de secteurs », notamment la 5G, la vidéosurveillance, l’internet des objets, l’informatique en nuage ou l’IA [12]. La précédente communication allait dans le même sens : « la transition requiert également une plus grande innovation technologique dans les secteurs de l’énergie, de la construction, des transports, de l’industrie et de l’agriculture. Des avancées dans le domaine de la numérisation, de l’information et des communications, de l’intelligence artificielle et de la biotechnologie permettront de donner un coup d’accélérateur » [13]. Sommes-nous bien certains que ces technologies seront disponibles, généralisables et généralisées dans la temporalité impartie (2050), et qu’elles auront bien l’effet attendu ? Bien au contraire. « Le numérique est un formidable levier pour la transition écologique si nous accompagnons son évolution pour réduire ses impacts environnementaux », assure Cédric O., secrétaire d’État chargé de la transition numérique. « [La transition numérique] nous permettra d’éviter la saturation des réseaux 4G en déployant des équipements significativement plus respectueux de l’environnement […]. C’est enfin une opportunité extraordinaire pour la transition écologique, grâce notamment aux gains de consommation (matières premières, énergie, ressources naturelles, etc.) permis par l’internet des objets » [14]. Vraiment ? En l’état, plus de débit conduira à plus de consommation, tout comme les gains en optimisation : c’est l’effet rebond. L’Europe se contente en réalité de reprendre le discours que tient laGlobal e-Sustainability Initiative (GeSI) [15], un consortium d’industriels qui depuis près de 15 ans chante les vertus du digital pour la réduction des émissions dans les autres secteurs. En 2008, le GeSI promettait 20 % de réduction des émissions de GES globales d’ici 2020, grâce au numérique. Nous y sommes. Or non seulement les émissions n’ont pas baissé dans les autres secteurs, pourtant massivement numérisés, mais la consommation du secteur numérique lui-même a doublé. Devant de si mauvais résultats, même le GeSI ne tient plus ce discours lénifiant du numérique qui sauverait la planète : il appelle le numérique et ses acteurs à se doter d’un but (a purpose) [16] ; un but donc qui ne soit pas plus de débit ni d’optimisation à des fins de poursuite de la croissance.

Car les projections sont plus noires encore. Si l’on explore l’avenir sur la base de ce qu’anticipent les industries, à la manière du Shift Project qui se nourrit des chiffres de Cisco ou de ceux du Global System for Mobile Communications (GSMA), un consortium d’entreprises dans le domaine du mobile [17], la conclusion est qu’en l’absence d’un changement de cap important, le numérique pourrait annihiler à lui seul au moins 20 % des réductions d’émissions nécessaires à la trajectoire de l’Accord de Paris [18]. Non pas - 20 %, mais + 20 %! Et le Shift souligne que Cisco a été prudent, jusqu’ici, en dépit de chiffres de croissance affolants : il montre que chaque année, l’équipementier a sous-estimé la croissance du trafic [19]. HP se réjouit d’ailleurs de perspectives plus affolantes encore : « l’univers digital double tous les deux ans, et devrait atteindre 20 milliards d’objets mobiles et un milliard d’applications en 2020 » [20].

Internet a souvent été comparé à l’imprimerie [21], à la suite des travaux d’Elizabeth Eisenstein [22], elle-même inspirée par McLuhan [23] (lui-même par Innis [24]). Cette analogie ramène souvent internet au texte, plus qu’à l’image. Or l’image est bien plus vorace que le texte, en information, et donc en énergie. Les jeux vidéo, par exemple, sont en forte croissance : leur part passe de 1 % à 4 % du trafic mondial, entre 2017 et 2022, d’après Cisco. Et Microsoft affirme ceci : « Amazon et Google s’efforcent de voir comment amener 7 milliards de personnes vers le jeu autour du monde. C’est le but » [25]. C’est là que vont aller les investissements. Apple se lance aussi avec Apple Arcade. Or si une Switch consomme 10-15 W en fonctionnement [26], un joueur « extrême » sur PC peut consommer autant qu’un foyer, à lui seul ; et le jeu sur Cloud s’avère bien plus vorace : en streaming un terminal de 10 W peut provoquer jusqu’à 520 W de consommation dans les centres de données. En Californie, la consommation du jeu n’est précédée, dans l’ordre de grandeur, que par la réfrigération et l’éclairage : il consomme à peu près autant que la climatisation et la télévision [27]. Cisco interroge : « si le “cloud gaming” devient populaire, il peut rapidement devenir l’une des catégories principales de trafic sur internet » [28].

L’usage de l’image n’a pas de limites perceptibles. Une caméra 64 Mp (mégapixels, millions de pixels), que l’on trouve dans le commerce, produit des images de 1 Go [29] ; une vidéo réalisée avec cet appareil enchaîne les images de 1 Go les unes à la suite des autres, au rythme de 10 à 60 par seconde. Sachant qu’un Français consomme en moyenne 6 Go/mois sur son smartphone, et 140 sur sa box [30]. Prenons un exemple plus accessible : les caméras de surveillance, qui représentent un marché en croissance de 10 %/an. Un modèle 0,3 Mp [31] coûte 100 euros, voire 200 pour une caméra HD (1 à 2 Mp). À raison d’une fréquence ordinaire de 8 à 15 images images/seconde, la caméra produit facilement 50 Mo/s, soit 300 Go/heure. Elle peut potentiellement équiper quelques milliards de bâtiments. Certes, on peut objecter que rien n’y contraint, que l’image peut rester sur place, ne pas être conservée, être compressée (aujourd’hui la compression conduit à des débits de 1Mo/s, et non 50 [32]), etc. Certes. Faut-il encore que cette préoccupation soit mise à l’agenda. Et si elle l’est, se passer tout simplement de ces caméras serait encore moins consommateur. D’autres usages incroyablement voraces se profilent sans le moindre souci écologique. Citons la « vidéo volumétrique », à base de caméras 5K, qui génère un flux de 3 To… par minute ! Soit 50 Go/s. Un film « volumétrique » de 2 heures « pèserait » donc pas moins de 180 To (180 000 Go). Et Intel estime sans sourciller que ce format est « le futur d’Hollywood » [33].

Il n’y a donc pas de surprise à ce que la vidéo représente l’essentiel de la consommation numérique. Les statistiques sont claires : Netflix représente aujourd’hui 15 % du trafic internet global, YouTube 11,4 %, Amazon Prime vidéo 3,7 %. Le téléchargement sur Playstation représente à lui seul le chiffre incroyable de 2,7 % du trafic total [34]. Le web (HTTP) classique culmine à moins de 10 %, ce qui inclut donc entre autres choses les requêtes Google (ouf ! se disent les universitaires). Sur Mobile, YouTube fait 37 % du trafic. Les réseaux sociaux sont aussi un facteur majeur de trafic, car ils sont riches en images : Snapchat 8,3 % du trafic, Instagram 5,7 %, Facebook 8,4 %, WhatsApp 3,7 %, Netflix 2,4 % [35]. Quoi de plus facile que de poster une vidéo ou une image sur WhatsApp ? Tout est pensé pour le faciliter. D’après Cisco le trafic vidéo passe de 50 Eb (exabytes) en 2017 à près de 300 en 2022 : + 33 %/an : un triplement tous les 5 ans.

Le Shift stigmatise les vidéos porno [36], mais quid des applications « immersives » qui peuvent très bien aller jusqu’à créer des communautés entièrement disjointes physiquement, de manière très « réaliste », avec non seulement l’image (« volumétrique »), mais les données tactiles et autres ? La science-fiction l’a anticipé, ainsi les films Code Rouge ou Matrix. Et l’IA, la voiture autonome, etc. ? Quelle sera la quantité de calcul ou de trafic nécessaire ? Elle se chiffrera sans doute en unités encore inconnues, puisqu’il n’y a rien, pour le moment, au-delà du yottabyte (=1 000 000 d’exabytes)...

Les écrans plats et indéfiniment extensibles ont en outre l’intérêt de pouvoir être disposés partout, pas seulement à la maison ou en usage mobile. Les célèbres écrans de Times Square, bien qu’étant désormais équipés de LED, consomment malgré tout 160 MW : près de 20 % d’une centrale nucléaire [37]. Un panneau numérique urbain à deux faces consomme 12 fois plus que son équivalent déroulant papier [38], soit autant que 3 foyers (12 000 kWh/an) ; et encore la facture paraît sous-estimée car JCDecaux ne semble pas envisager un fonctionnement 24/7, alors que tel est souvent le cas [39].

Un autre objet mis en avant tant par le GSMA que par le Green Deal est la voiture connectée, ou « autonome ». En 2016, Intel annonçait que l’objet consommait 4 petaoctets… par jour [40], sachant qu’en 2020 une personne génère ou fait transiter 2 Gb/j : 2 millions de fois plus. Récemment Thierry Breton, PDG d’ATOS, réévaluait ce chiffre à 30 petaoctets de données par jour, et il ajoutait : « c’est absolument gigantesque. Aucun réseau ne peut supporter cela. La fonction de traitement de données du véhicule électrique ou de la voiture autonome sera sans doute plus consommatrice d’énergie que sa fonction de mobilité. C’est un sujet dont on ne parle pas aujourd’hui » [41]. D’autres sources évoquent 4 à 10 Tb/jour, équivalent à 6 200 usagers d’internet [42]. Les principaux moteurs de consommation sont les caméras (20 à 60 Mo/s) et le LIDAR, appareil fondé sur l’écho d’un laser (entre 10 et 70 Mo/s).

Et la voiture autonome n’est finalement qu’un cas particulier de « l’IA » et du « big data » (données massives ou mégadonnées). Strubell, Ganesh et McCallum ont montré, à partir d’un réseau de neurones courant utilisé pour traiter le langage naturel, qu’une séance d’entraînement consommait 350 tonnes de CO2 [43], soit 300 allers-retours New York-San Francisco. Là encore l’usage d’images voire de vidéos est déterminant [44]. De plus la masse de données et la complexité de l’architecture sont telles que l’arrêt de la machine peut difficilement être anticipé à l’avance : il faut la laisser tourner jusqu’à ce que le résultat soit stabilisé [45].

L’ordinateur quantique peut-il prendre le relais ? Sa consommation semble insensible à la puissance de calcul appelée, pour le moment, mais celle-ci est très faible, relativement à la puissance de refroidissement nécessaire, dans la mesure où ce type d’ordinateur fonctionne à une température proche du zéro absolu : - 273°C. Plusieurs publications laissent penser que la consommation d’énergie pourrait augmenter fortement lorsque ces machines deviendront plus puissantes, notamment des considérations de physique fondamentale [46]. De plus le quantique, c’est l’invention, là encore, pas l’innovation : combien de temps faudra-t-il pour jouer un rôle significatif dans « l’écosystème » de calcul global ? Les projections indiquent également que le quantique sera utilisé dans le Cloud, en raison de la taille des machines ; le quantique agira donc comme un accélérateur de l’ensemble du monde numérique, tirant les consommations sur toute la chaîne [47]. Le mode de fonctionnement très particulier conduit à des débouchés se situant surtout dans le domaine de l’optimisation, ce qui, toutes choses égales par ailleurs, conduira à « l’effet rebond ». Rappelons en effet qu’Harty D. Saunders a montré dans un article déjà ancien du Energy Journal [48] que dans le cadre de l’économie néoclassique, des acteurs cherchant leur intérêt économique vont toujours convertir les gains en efficacité énergétique ou matérielle en consommations croissantes, et donc toujours générer l’effet rebond.

« Il faut 25 ans – une génération – pour transformer un secteur industriel et toutes les chaînes de valeur. Pour être prêts en 2050, nous devons prendre des décisions et des mesures dans les cinq années à venir » [49]. Urgence, mobilisation, oui, mais pour quoi faire ? Pour s’assurer de ne pas avoir été largué dans la course à la voiture autonome, même si elle ne mène nulle part ? Pour avoir équipé le continent entier en 5G 6G 7G, même si cela fait exploser la consommation de données et place chaque individu dans une situation de dépendance extrême envers le numérique ? Même si cela prive les autres solutions disponibles ici et maintenant de sources de financement ? Un simple exemple, dans le domaine crucial du transport : le scénario « au fil de l’eau » de l’OCDE [50] s’attend à un triplement du transport passager entre 2015 et 2050, facilité par le véhicule autonome, et non empêché par lui. Autant dire que cet outil ne garantit rien, bien au contraire. S’attaquant à ce problème, le Shift Project propose des solutions qui n’ont rien de très techno, mais qui sont immédiatement efficaces [51] : dans le Green Deal, ces pistes, essentielles et efficaces, resteront tout simplement sans financement, quand les secteurs les plus incertains, en termes de résultat, seront gavés de lignes de crédit.

En analysant un peu on se rend donc compte que les solutions proposées par le Green Deal sont de l’ordre de l’efficacité, et non de la sobriété. Elles s’inscrivent dans une société de croissance, non seulement qu’elles ne remettent pas en cause, mais qu’elles financent, puisqu’il est attendu des solutions vertes qu’elles soient rentables : l’argent ainsi dégagé pourra être employé pour dépenser plus, suivant le schéma inauguré avec Adam Smith voire le docteur Quesnay. De là évidemment cet « effet rebond » qui n’est même pas évoqué dans le Green Deal. Une étude récente le montre et ce résultat n’a rien de surprenant : dans le cas du numérique, les effets rebond se sont montrés plus importants que les gains apportés par l’innovation technologique [52]. Les bénéfices environnementaux du télétravail sont par exemple largement inférieurs à ceux intuitivement escomptés [53], en tout cas lorsqu’il n’est pas combiné à d’autres changements de l’écosystème social. C’est une conséquence évidente puisque tel est bien le but recherché.

En croyant ou en laissant croire que les bonnes performances ont enclenché une dynamique positive en termes de modes de vie, l’Europe s’illusionne. Il n’est dans le fond question que d’efficacité. Or celle-ci a des limites, y compris dans le domaine du numérique où ils semblent si colossaux. Le premier ordinateur, l’ENIAC, pesait 30 tonnes, consommait 150 000 watts et ne faisait guère plus de 5 000 opérations par seconde [54]. Un PC actuel équipé d’une carte Nvidia Titan, qui dispose de 576 cœurs et de 130 Tflops de puissance de calcul, ne consomme que 200 à 300 W ; c’est autant de puissance que le meilleur supercalculateur de 2003, qui consommait 1,5 MW [55] ! Époustouflant. Sauf qu’une limite absolue a été identifiée dès 1961 [56], et vérifiée en 2012 [57] : la « limite de Landauer ». Divers documents dont ceux du Shift Project [58] ou de l’industrie des semi-conducteurs elle-même [59] convergent pour affirmer que la limite se rapproche rapidement, cela alors que la consommation de trafic et de puissance de calcul augmente de manière exponentielle. La probabilité pour que le numérique devienne un énorme pôle de consommation augmente rapidement. Le document cité de l’industrie évoque une consommation de l’ordre de la totalité de l’énergie mondiale, en 2050. En matière d’efficacité, les gains les plus faciles d’accès (« low hanging fruits ») se trouvent en général au départ, rarement à l’arrivée. Le cas du numérique est exemplaire à cet égard.

L’erreur vient aussi de l’analogie trompeuse entre Internet et l’imprimerie déjà mentionnée. Le numérique, c’est ce qui permet aux sociétés industrielles de fonctionner, c’est-à-dire de (se) programmer, et pas seulement de s’informer. Norbert Wiener avait déjà nettement conscience de l’enjeu, dès 1948, quand il affirme que le numérique, c’est l’information, certes, mais aussi l’automatique, c’est-à-dire la commande [60]. Et la commande du mouvement, ou fonctionnement, est une composante essentielle des modes de vie industriels, capitalistes, thermoindustriels ou productivistes : sans cela, pas de déplacement de matière et d’énergie, dans la biosphère. Rapprocher le numérique de l’information, au sens cognitif du terme, c’est avoir en tête le web, plus que l’Internet. Internet, c’est Amazon, c’est-à-dire la logistique. C’est pourquoi il est plus juste de parler de « digitalisation de l’économie », comme la CNUCED [61], ou Manuel Castells [62], que de se concentrer sur le web. Pascal Lamy, directeur de l’OMC, estimait d’ailleurs que la mondialisation reposait sur deux innovations : Internet et le conteneur [63]. De là le lien également avec les Postes, aussi bien qu’avec toutes les formes de gestion de la chaîne d’approvisionnement (supply chain management), en particulier le commerce « en ligne » (ecommerce ou mcommerce), qui ne sont jamais qu’une réorganisation de la chaine logistique, se situant dans la continuité des innovations dont la Ford modèle « T » peut être le symbole. À ceci près que ces chaînes sont désormais globalisées – global supply chain management. Et en effet le Pacte Vert insiste beaucoup sur la maîtrise des chaînes de valeur stratégiques – la maitrise, leur maintien et leur optimisation, pas leur transformation vers des modèles plus écologiques.

Nous devons nous rendre à l’évidence : le numérique est piloté par des acteurs qui n’ont aucune véritable motivation pour accomplir quelque chose comme une « transition écologique », si par là on entend se donner réellement les moyens de mettre en place des modes de vie compatibles avec l’égalité et avec les équilibres de la biosphère. Plus de numérique, ce sera plus de destruction, et non pas moins.

Notes

Fabrice Flipo est professeur de philosophie, épistémologie et histoire des sciences et techniques à l’Institut Mines-Télécom, il a beaucoup travaillé sur les liens entre numérique et écologie, et a notamment publié sur ce sujet : Fabrice Flipo, François Deltour, Michelle Dobré et Marion Michot, Peut-on croire aux TIC vertes ? Technologies de l’information et crise environnementale, Paris, Presses des Mines, 2012 ; et Fabrice Flipo, L’impératif de la sobriété numérique : l’enjeu des modes de vie, Paris, Éditions matériologiques, 2020.

Pour citer cet article

Fabrice Flipo

« Numérique. Le miroir aux alouettes de la transition écologique », Vocabulaire critique et spéculatif des transitions [En ligne],

mis en ligne le 20/04/2021, consulté le 03/03/2026. URL : https://vocabulairedestransitions.fr/article-9.